Il mondo dell’intelligenza artificiale è in continua evoluzione, e una delle ultime innovazioni promettenti arriva dai laboratori del MIT di Boston. Qui, una startup chiamata Liquid ha presentato una tecnologia AI che non solo migliora le prestazioni, ma lo fa consumando significativamente meno risorse rispetto ai modelli attuali.

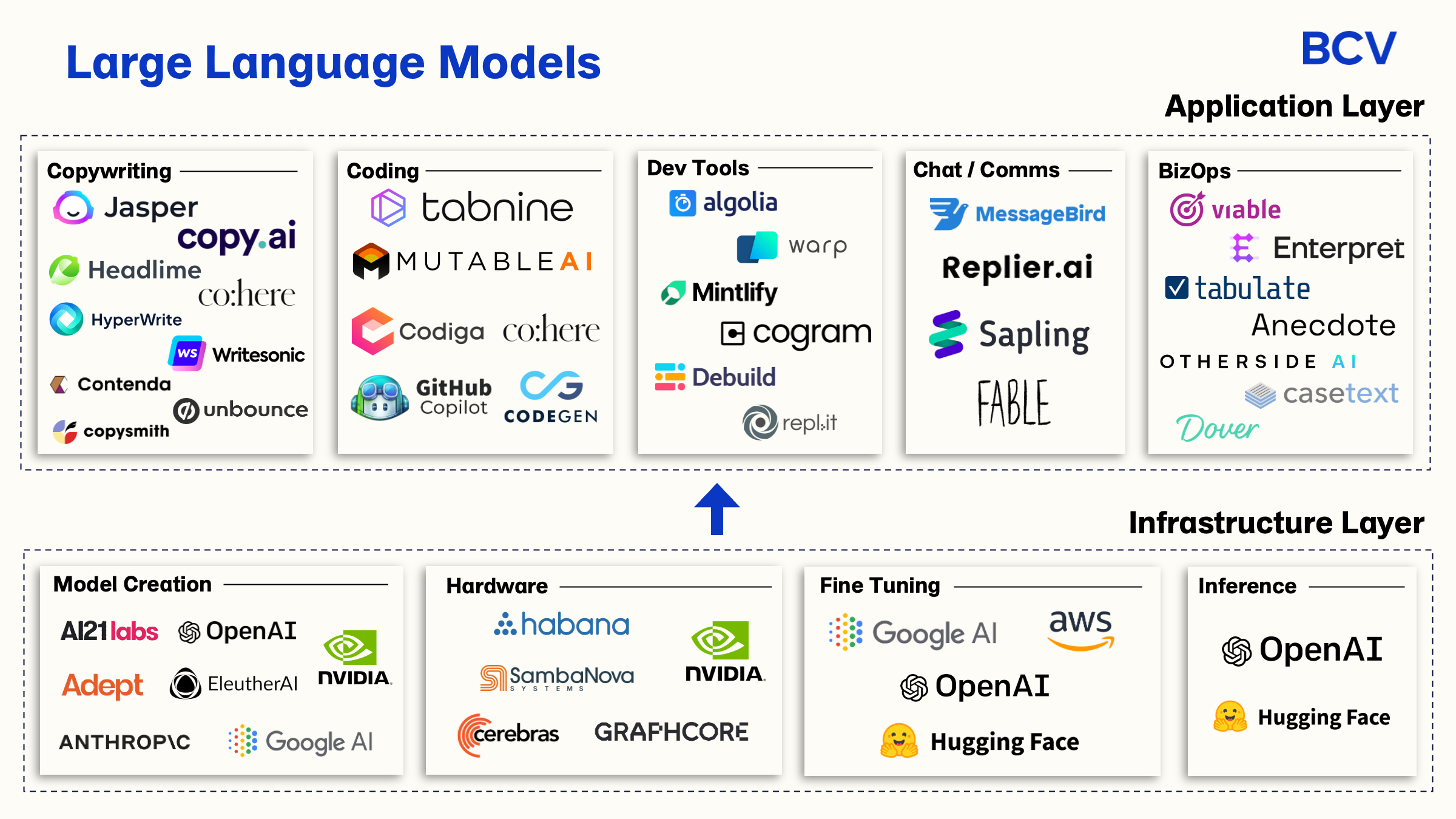

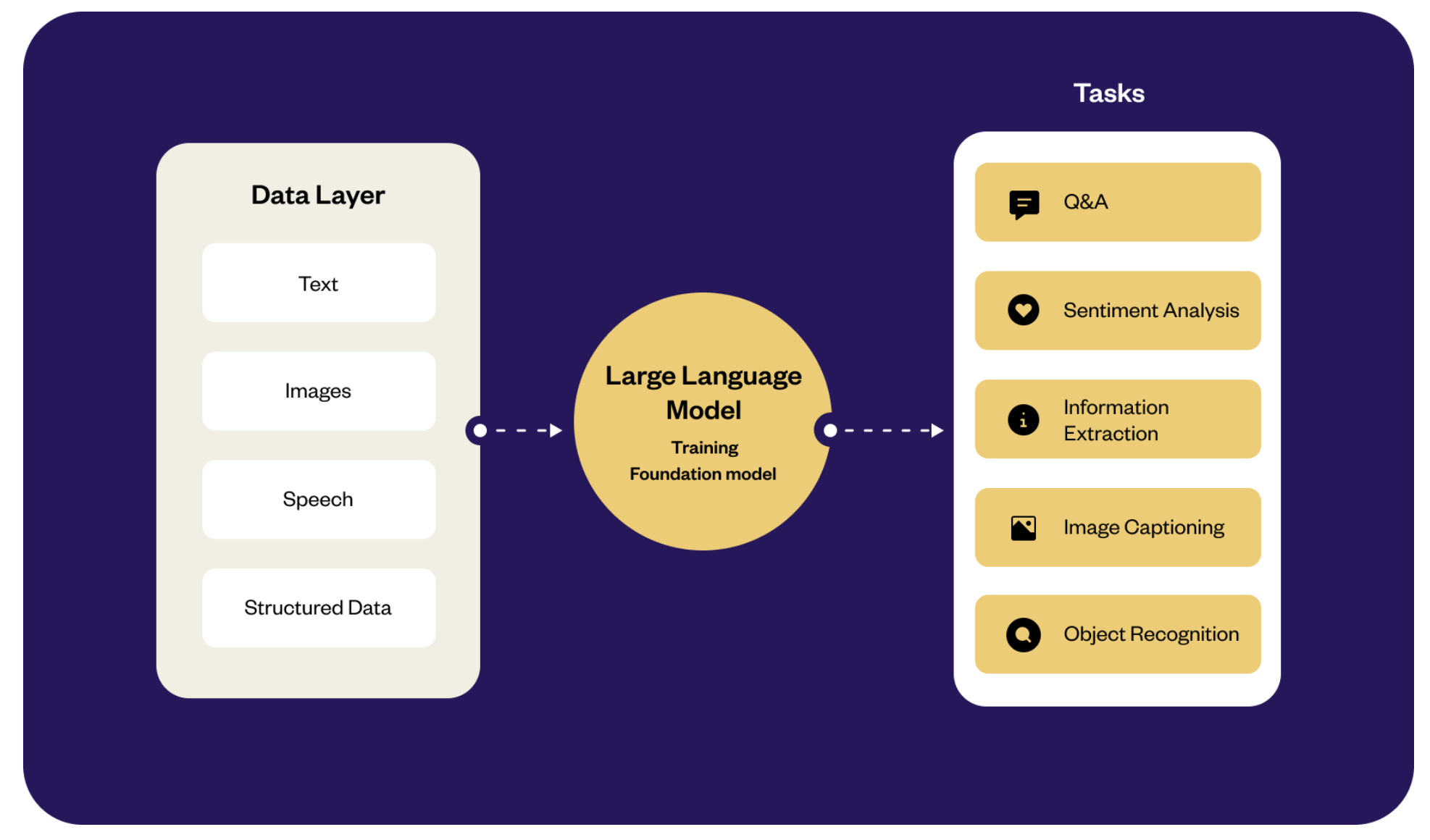

La novità si basa sui Liquid Foundation Models (LFM), una categoria di modelli che si distingue nettamente dagli Large Language Models (LLM) tradizionali, con cui abbiamo iniziato a familiarizzare negli ultimi anni. A differenza di modelli come GPT, Claude e Llama, gli LFM offrono una maggiore efficienza, riuscendo a svolgere le stesse mansioni con un utilizzo di memoria notevolmente ridotto.

Questi nuovi modelli utilizzano reti neurali con un numero inferiore di neuroni artificiali, ma riescono a combinarli in modi innovativi, garantendo così prestazioni che possono essere paragonabili o addirittura superiori a quelle dei modelli tradizionali basati su trasformatori. La conseguenza di questo approccio non è solo una gestione ottimale delle operazioni, ma anche un notevole risparmio energetico, un aspetto sempre più cruciale per il settore.

Le Caratteristiche Distintive degli LFM

Due elementi chiave rendono gli LFM particolarmente interessanti. In primo luogo, questi modelli hanno la capacità di adattarsi in tempo reale agli input degli utenti senza il pesante fardello computazionale tipico degli LLM. Questo permette loro di essere estremamente rapidi in compiti specifici. In secondo luogo, sono in grado di gestire sequenze di dati lunghe fino a 1 milione di token, un’impresa che richiede uno sforzo considerevole per un modello tradizionale. Per dare un’idea, ciò consente loro di analizzare un intero libro in un singolo colpo.

Liquid AI ha introdotto tre varianti del modello LFM: il compatto 1.3B, l’equilibrato 3B, e il robusto 40B MoE che adotta un approccio noto come Mixture-of-Experts. La lettera “B” indica i miliardi di parametri che sono alla base del funzionamento del modello. Durante le prove, l’LFM-3B ha mostrato performance superiori in termini di efficienza della memoria rispetto a giganti del settore come Gemma-2 di Google, Phi-3 di Microsoft e Llama-3.2 di Meta.

Applicazioni Potenziali e Futuro degli LFM

Questa capacità di risparmiare memoria rende gli LFM ideali per gestire simultaneamente diversi tipi di media, inclusi video, audio e testo, il che apre a opportunità notevoli in settori complessi come la finanza, la biotecnologia e l’elettronica di consumo. Inoltre, grazie alla loro efficienza, possono funzionare anche su dispositivi più piccoli e autonomi, amplificando le possibilità di utilizzo.

Interessante è anche notare che il modello più ridotto, l’LFM 1.3B, è già in grado di superare concorrenti ben più grandi in test standardizzati come il MMLU, che esamina 57 aree di conoscenza. Anche se questi risultati sono impressionanti, è importante sottolineare che non sono stati ancora verificati da entità indipendenti, e la mancanza di open source degli LFM limita pari opportunità di scrutinio da parte della comunità scientifica.

Nel frattempo, Liquid sta lavorando per ottimizzare queste nuove classi di modelli affinché possano funzionare su diverse piattaforme hardware, inclusi chip di Nvidia, Amd, Apple, Qualcomm e Cerebras. Un importante evento di lancio è previsto al MIT il 23 ottobre 2024, dove verranno rivelati ulteriori dettagli tecnici e dimostrate le potenzialità degli LFM.

Conclusione: Un Salto Evolutivo nell’AI?

In sintesi, gli LFM non si limitano a migliorare l’efficienza energetica, ma introducono anche un concetto rivoluzionario nel modo in cui l’intelligenza artificiale potrebbe operare in futuro. Se queste innovazioni si concretizzeranno come promesso, potremmo assistere a un’era di AI più efficienti in settori che oggi richiedono una grande quantità di potenza di calcolo. Per ora, resta da vedere se questi modelli rappresenteranno davvero il passo avanti tanto atteso nel settore dell’intelligenza artificiale.