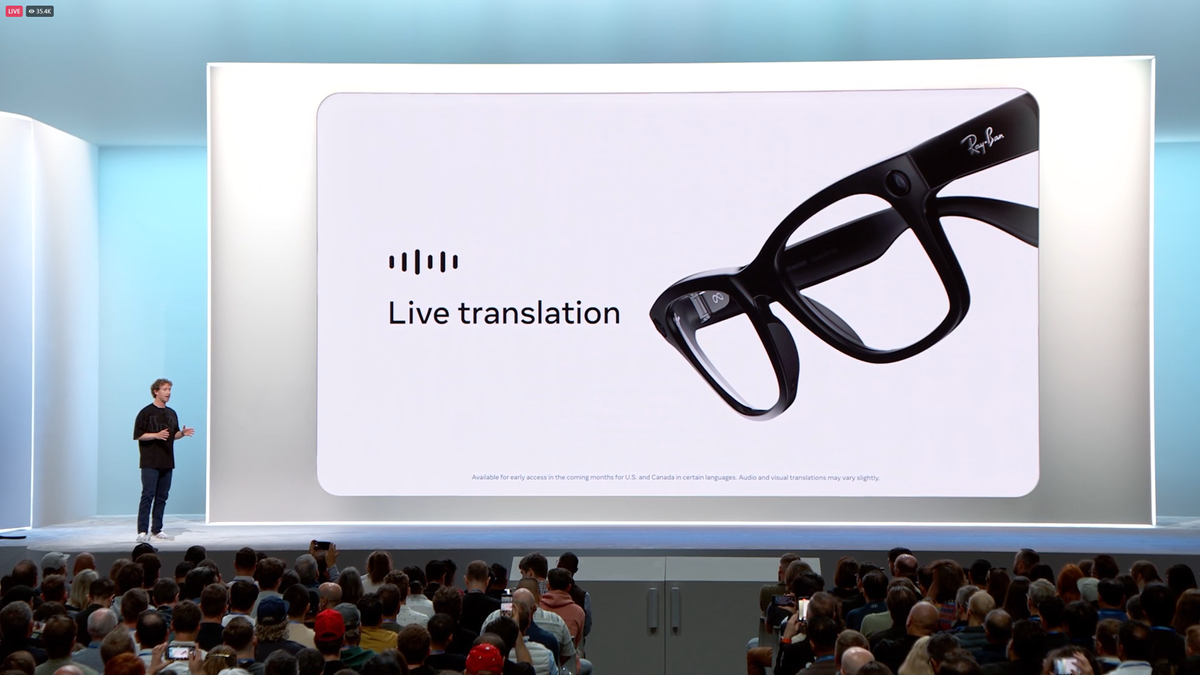

Meta ha recentemente annunciato il lancio di tre nuove funzionalità per i suoi occhiali intelligenti Ray-Ban, arricchendo ulteriormente l’esperienza utente e ampliando le possibilità d’uso. Le nuove caratteristiche includono AI in tempo reale, traduzioni live e supporto per Shazam. È importante notare che le funzionalità di AI e traduzione in tempo reale sono disponibili attualmente solo per i membri del Programma di Accesso Anticipato di Meta, mentre il supporto per Shazam è accessibile a tutti gli utenti negli Stati Uniti e in Canada.

Queste innovazioni sono state inizialmente presentate durante il Meta Connect 2024 all’inizio di quest’anno, stupendo il pubblico con le loro potenzialità. La funzione di AI in tempo reale consente agli utenti di interagire in modo naturale con l’assistente AI di Meta, mentre questo continua a osservare l’ambiente circostante. Ad esempio, se ci si trova nel reparto ortofrutticolo di un supermercato, sarà teoricamente possibile chiedere all’assistente di suggerire alcune ricette basate sugli ingredienti che si stanno considerando.

Secondo Meta, la funzionalità di AI può essere utilizzata per circa 30 minuti di seguito con una singola carica, offrendo così un’ottima esperienza per compiti quotidiani. Dall’altro lato, la funzione di traduzione live permette di tradurre discorsi in tempo reale tra l’inglese e altre lingue come lo spagnolo, il francese o l’italiano. Gli utenti possono scegliere di ricevere le traduzioni direttamente negli occhiali o visualizzarle sul proprio smartphone, a seconda delle preferenze personali.

È fondamentale, però, scaricare in anticipo le coppie di lingue e specificare quali lingue si parlano per ottimizzare l’esperienza di traduzione. Queste funzionalità rappresentano un passo significativo verso una comunicazione più fluida e intuitiva nelle interazioni multilingue.

La funzionalità di Shazam è molto più semplice da utilizzare. Gli utenti devono solo attivare l’assistente AI di Meta quando sentono una canzone, e questo sarà in grado di identificare il brano in riproduzione. Meta ha persino condiviso un video su Instagram in cui il CEO Mark Zuckerberg mostra il funzionamento del servizio, evidenziando quanto sia immediata la tecnologia.

Per coloro che non vedono ancora queste nuove funzionalità, è consigliato controllare che gli occhiali siano aggiornati alla software v11 e che l’app Meta View sia aggiornata alla versione v196. Se non si fa parte del Programma di Accesso Anticipato, è possibile fare domanda tramite il sito ufficiale di Meta, per avere accesso anticipato alle ultime novità.

Questi aggiornamenti arrivano proprio in un momento in cui le grandi tecnologie stanno puntando fortemente sugli assistenti AI come motivo principale per l’adozione di occhiali intelligenti. Solo una settimana fa, Google ha presentato Android XR, un nuovo sistema operativo per occhiali intelligenti, posizionando in modo specifico il suo assistente AI Gemini come la killer app del futuro.

Nel frattempo, Andrew Bosworth, CTO di Meta, ha recentemente pubblicato un blog in cui afferma che il 2024 sarà l’anno in cui gli occhiali AI daranno il meglio di sé. In questo post, Bosworth sostiene anche che gli occhiali intelligenti potrebbero rappresentare il miglior formato possibile per un “dispositivo realmente nativo AI” e che saranno la prima categoria di hardware completamente definita dall’AI fin dall’inizio.

Visualizza questo post su Instagram